生産性の向上、

しかしリスクは増大

AIコーディングツール、大規模言語モデル(LLM)、機械学習プラットフォーム(MCP)の普及は新たな課題をもたらしている。AIが生成したコードに対する可視性とガバナンスの欠如である。

78%

- スタックオーバーフロー

30%

- arXiv

50%

- バックスベンチ

トラスト・エージェントのメリットAI

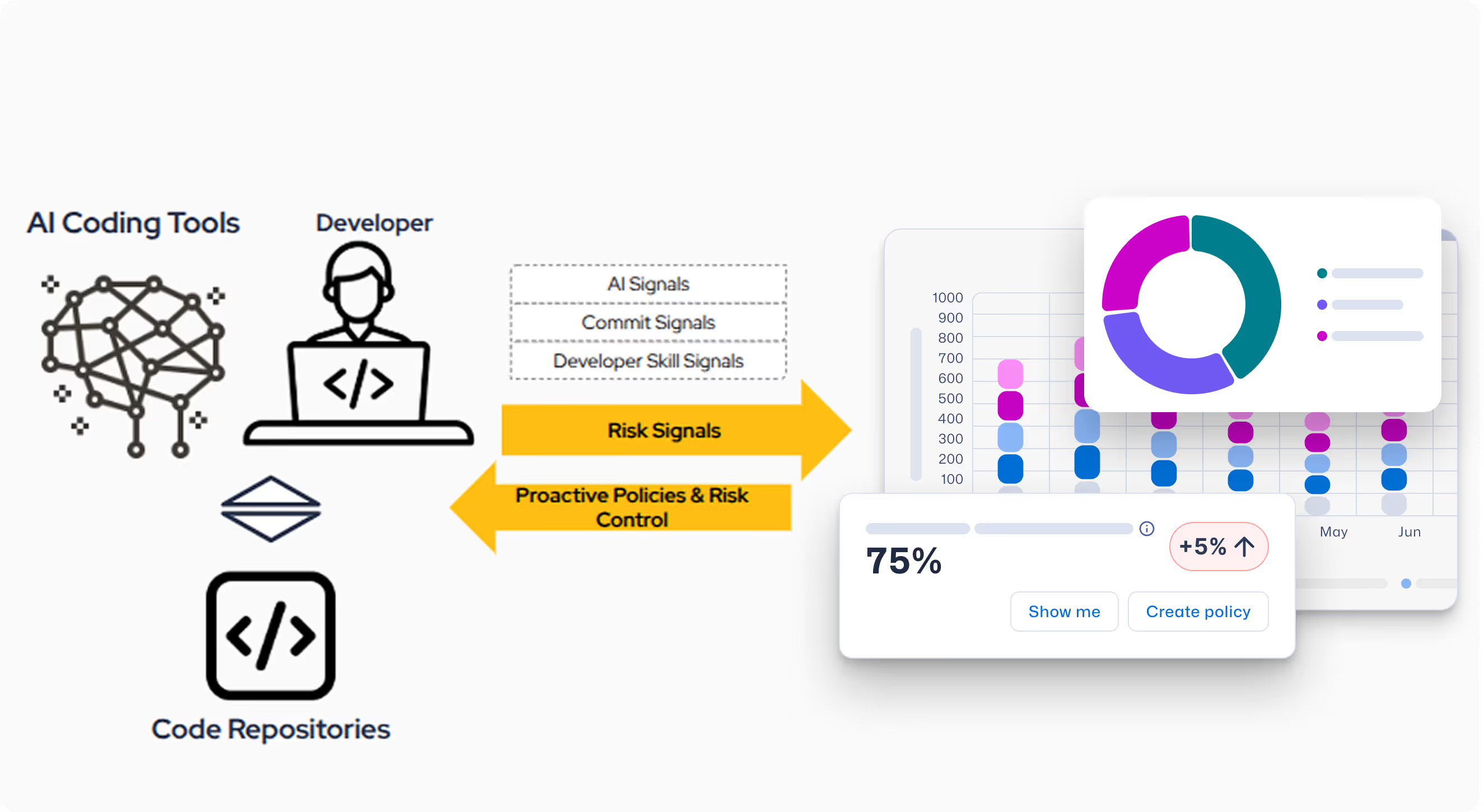

SCW Trust Agentの新しいAI機能は、セキュリティを犠牲にすることなく、ソフトウェア開発ライフサイクル(SDLC)におけるAIの採用を自信を持って管理するために必要な、深い観測性と制御性を提供します。

SDLCにおけるAIの課題

AIの利用を管理する方法がなければ、CISO、AppSec、エンジニアリングのリーダーは、新たなリスクや答えのない疑問にさらされることになる。いくつかの懸念事項を挙げよう:

- どの開発者がどのモデルを使用しているかが見えない。

- AIコーディングツールを使用する開発者のセキュリティ能力に関する不確実性。

- コントリビュートされたコードの何パーセントがAIによって生成されたものなのかについての洞察はない。

- AIコーディングツールのリスクを管理するためのポリシーとガバナンスを実施できない。

ソリューション -

Trust Agent:AI

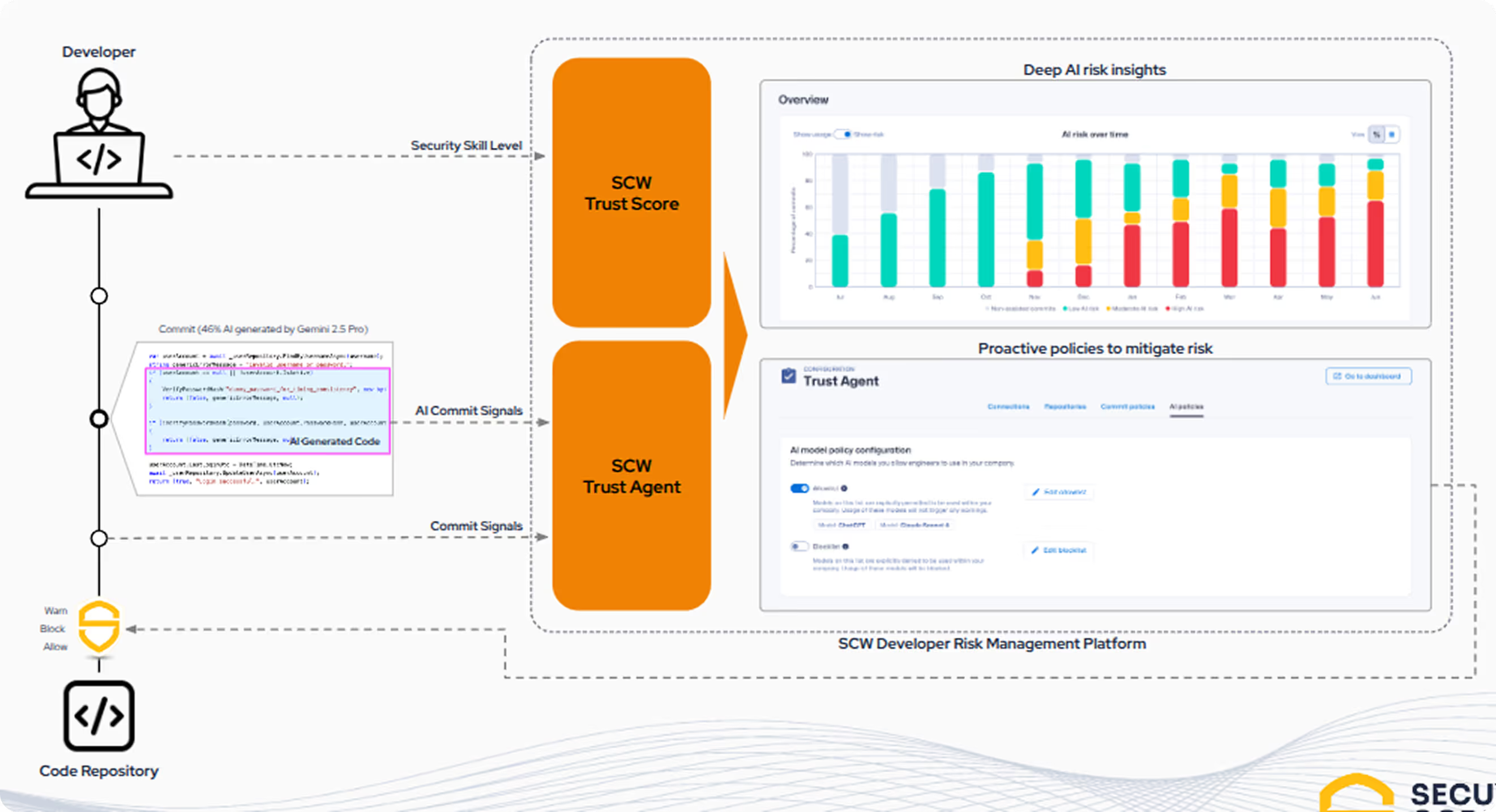

SCWは、セキュリティを犠牲にすることなく、AI主導の開発スピードを組織に提供します。トラスト・エージェントAIは、コミット・レベルでAI支援開発者のリスクを理解するために、3つの重要なシグナルのユニークな組み合わせを相関させることにより、可視性とガバナンスを提供する最初のソリューションです。

- AIコーディングツールの利用状況:どのAIコーディングツール、大規模言語モデル(LLM)、機械学習プラットフォーム(MCP)を誰が、どのコードリポジトリで利用しているかの分析。

- リアルタイムで信号を捕捉トラスト・エージェント:開発者のコンピューターとIDE上でAIが生成したコードをAIが傍受する。

- 開発者のセキュアコーディングスキルAIを責任を持って使用するために必要な基礎スキルである、開発者のセキュアコーディング能力を明確に把握します。

"影のAI "はもういらない

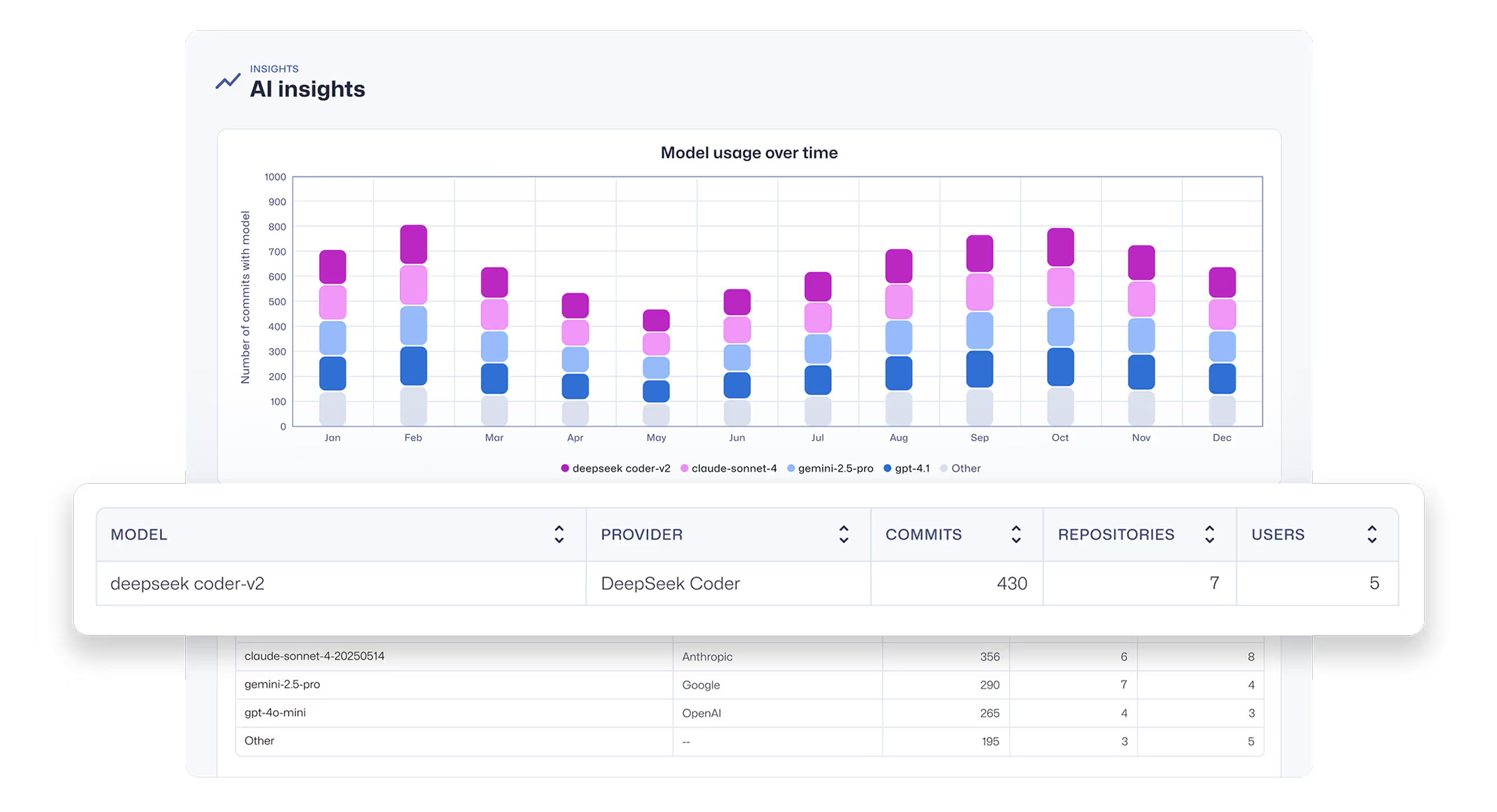

AIコーディングアシスタントとエージェントの全体像と、それらを動かすLLMを把握する。未承認のツールやモデルを発見する。

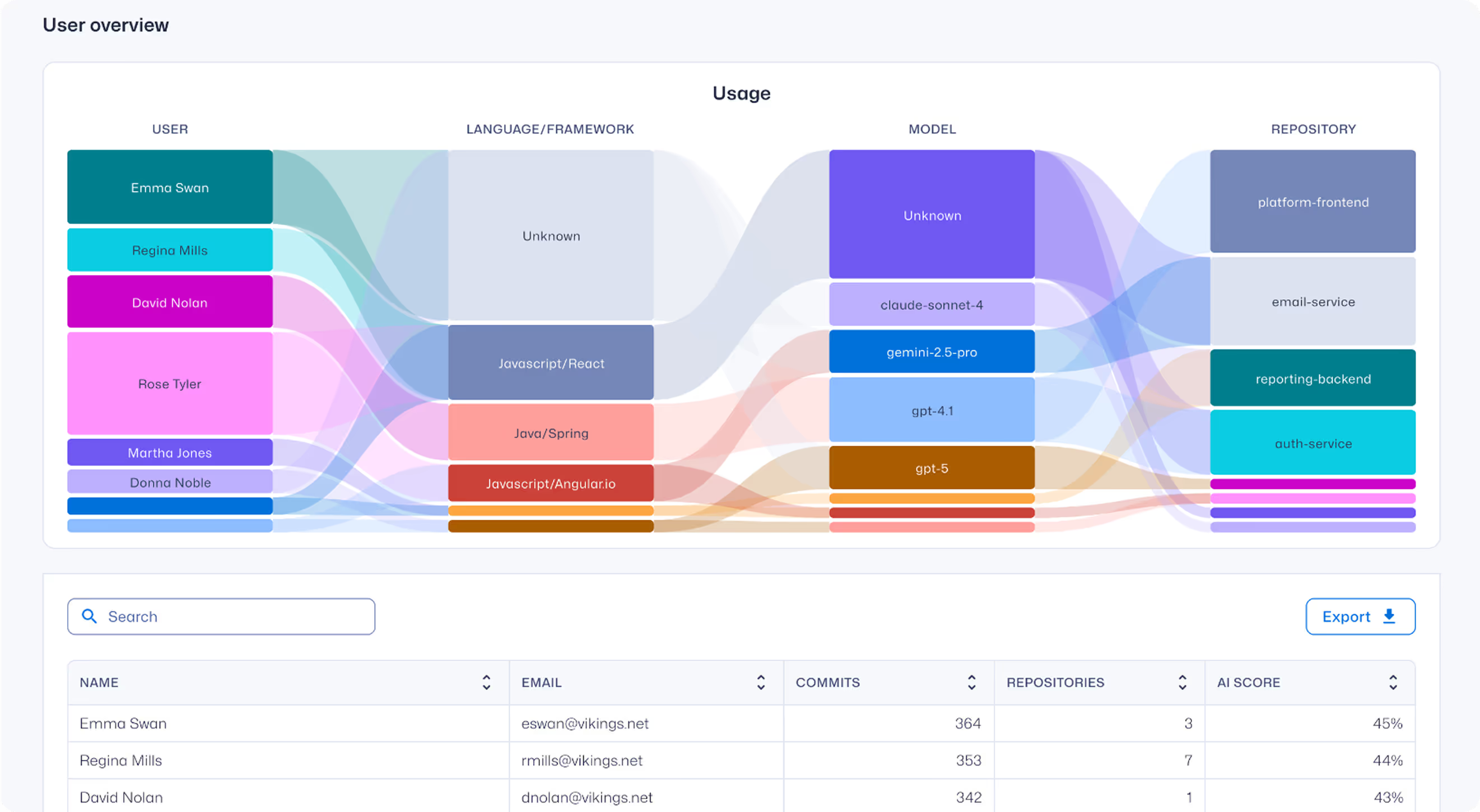

コミットへの深い観測可能性

AI支援型ソフトウェア開発に関する深い可視性を獲得します。具体的には、どの開発者がどのLLMモデルやMCPを利用しているか、またどのコードベースで利用しているかといった情報を把握できます。

統合されたガバナンスとコントロール

AIが生成したコードと実際のコミットを結びつけ、導入されている真のセキュリティリスクを把握する。ポリシーの適用を自動化し、AIを使用できる開発者が、その貢献を受け入れる前にセキュアなコーディング基準を満たしていることを確認する。

Trust Agentについての質問:AIインサイト

SDLCにおいて、なぜAI/LLMが生成するコードのリスクを気にする必要があるのか?

開発者がAIコーディングツールをますます活用するようになるにつれて、SDLCに重大な新しいリスク層が導入されつつある。調査によると、開発者の78%が現在これらのツールを使用しているが、AIが生成したコードの50%にセキュリティ上の欠陥があることが調査で明らかになっている。

このようなガバナンスの欠如と、開発者の知識とコードの品質との間の断絶は、すぐに制御不能に陥る可能性がある。安全でないAIが生成したコンポーネントが、組織の攻撃対象領域を増やし、リスク管理とコンプライアンス維持の取り組みを複雑にするからだ。

詳細はホワイトペーパーをご覧ください:AIコーディングアシスタント:次世代開発者のためのセキュリティセーフナビゲーションガイド

Trust Agent.AIが検出するモデルとツールとは?AIが検出するのは?

トラスト・エージェント:AIは、GitHub Copilot、Cline、Roo CodeなどのAIアシスタントやエージェント型コーディングツール、およびそれらを動かすLLMからシグナルを収集する。

現在、OpenAI、Amazon Bedrock、Google Vertex AI、Github Copilotが提供するすべてのモデルを検出している。

Trust Agent.AIはどのようにインストールされますか?AIはどのようにインストールされますか?

Visual Studio Codeで手動インストールするための.vsixファイルを提供し、Intune、Jamf、Kanji用のモバイルデバイス管理(MDM)スクリプトによる自動デプロイメントを近日中に提供する予定です。

Trust Agentに登録するには?AI?

Trust Agent: AIは現在ベータ版です。ご興味のある方は、早期アクセス待機リストにご登録ください。

%201.avif)

.avif)

.avif)